뉴스

"파라미터"(으)로 총 30건 검색되었습니다.

- 또 한번의 '딥시크 모먼트'…中 문샷 AI, 키미 K2 출시동아사이언스 2025.07.17

- 규모는 1조 개에 달하지만 혼합 전문가(MoE) 모델 구조를 이용해 계산 효율을 높였다. 파라미터는 함수나 모델의 특성을 결정하는 변수를 뜻한다. MoE 모델 설계 방식은 필요한 전문가 네트워크만 사용하는 식으로 훈련과 추론에 필요한 계산량을 크게 줄인다. 이를 통해 고가의 그래픽처리장치(GPU) ... ...

- [과기원NOW] 포스텍, 눈물막 유지하는 '결막 술잔세포' 광학 현미경으로 관찰 外동아사이언스 2025.04.21

- 제안했다. 행동 변화에 따른 누적 보상 값의 변화가 지나치게 커지지 않도록 정책 파라미터 공간에서 누적 보상의 곡면을 평탄하게 만드는 학습 전략이다. 연구팀이 제안한 방식은 정책이 조금 바뀌어도 성능이 일정하게 유지된다. 기존 학습법은 동일 조건에서 평균 보상이 절반 이하로 감소하는 ... ...

- 서버 안 올려도 셀카를 지브리풍으로…사생활 보호하는 AI동아사이언스 2025.04.09

- AI 모델 개발은 별도로 필요하다”고 말했다. 연구팀은 모든 정보를 공유하는 대용량 파라미터 방식 대신 중요 정보만 선별해 공유하는 ‘이진 마스크’ 방식을 적용해 프리즘의 통신 효율을 높였다. 생성 품질을 정밀하게 평가하는 손실 함수(MMD)와 각전 로컬 AI의 기여도를 집계하는 략(MADA)으로 ... ...

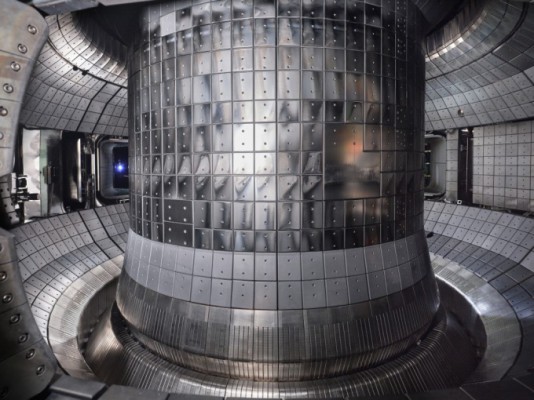

- '한국형 혁신 핵융합에너지 상용화' 논의 수면 위로동아사이언스 2025.04.01

- 필요하다"고 강조했다. 윤시우 핵융합연 부원장은 '혁신형 핵융합로 도입에 따른 주요 파라미터 제안 및 단계별 추진 전략'을 발표했다. 윤 부원장은 기존 토카막 방식 핵융합 장치보다 작지만 성능이 뛰어난 '한국형 혁신 핵융합로'를 제안하고 개발에 필요한 핵심 기술을 설명했다. 혁신형 핵융합로 ... ...

- 원자력 AI에이전트 꿈꾸는 언어모델 'AtomicGPT' 공개동아사이언스 2024.12.11

- 연구팀은 AtomicGPT를 파라미터 규모가 각각 80억 개, 700억 개인 두 가지 버전으로 개발했다. 파라미터 규모가 클수록 답변의 수준이 높아진다. 용도에 따라 소규모 버전은 빠르고 가벼운 검색에, 대규모 버전은 어려운 질의응답을 위해 사용된다. 연구팀은 AtomicGPT를 문서 업무 활용뿐 아니라 원전 ... ...

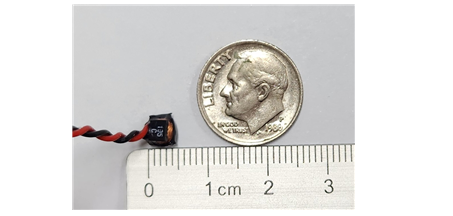

- 3.5mm 초소형 코일로 뇌 자극한다동아사이언스 2024.12.04

- 제시한 결과”라며 “TMS 치료 시 병원을 주기적으로 방문하고 매번 코일과 자극 파라미터 설정을 위한 보정 작업이 필요했던 등의 단점을 극복할 수 있을 것” 이라고 설명했다. 연구 결과는 국제학술지 ‘뇌 자극’에 지난달 13일 표지논문으로 게재됐다. - 10.1016/j.brs.2024.10.001 연구 ... ...

- [사이언스게시판] ETRI, 한국어 생성형 언어모델 공개 外동아사이언스 2024.11.28

- 오픈소스 플랫폼인 '허깅페이스'에 공개했다고 28일 밝혔다. 연구팀이 개발한 30억개 파라미터 규모의 소형 언어모델은 한국어 데이터 비중이 높아 한국어 기반 숫자 연산 등에 적합하다. ■ 한국과학창의재단은 과학기술정보통신부와 과학영재 교육자들과 함께 성장하고 소통하기 위한 '2024년 ... ...

- 초고가 GPU 없어도 효율적 AI 학습시킨다동아사이언스 2024.09.19

- 효율적인 학습을 가능하게 한다. 이 기술을 활용하면 기존에 32~64개 GPU가 필요한 150억 파라미터 규모의 언어 모델을 단 4개의 GPU만으로도 학습할 수 있게 됐다. 이를 통해 학습의 필요한 최소 GPU 대수를 8배~16배 낮출 수 있게 됐다 ... ...

- 美 국방부 과제 'C언어 번역 기술' 韓 연구팀이 선도동아사이언스 2024.08.13

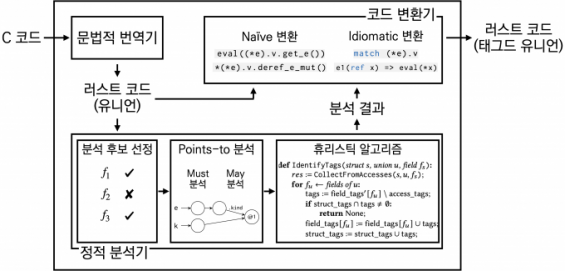

- 개발한 연구팀은 극소수다. 앞서 류 교수팀은 C언어의 기능인 '뮤텍스(mutex)', '출력 파라미터'를 C언어의 핵심 기능을 러스트로 변환하는 기법을 지난해 5월과 올해 6월에 각각 최초로 개발해 발표하며 C-러스트 코드 번역 기술을 선도하고 있다. 류 교수는 "안전한 소프트웨어 제작을 위해 C-러스트 ... ...

- AI 거대언어모델 0.4초만에 처리…삼성 28나노공정으로 초저전력 AI반도체 기술 개발동아사이언스 2024.03.06

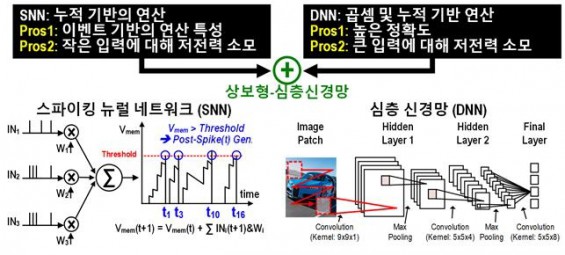

- 이번 연구는 거대모델의 파라메타 수를 줄이는 데에만 집중된 최근 연구 트렌드와 달리 파라미터 수 감소에 더해 초저전력 처리가 가능한 뉴로모픽 컴퓨팅을 거대언어 모델 처리에 적용해 에너지 효율을 극대화했다는 점에서 획기적이란 평가를 받는다. 연구팀은 향후 뉴로모픽 컴퓨팅을 언어 ... ...